Negli ultimi dieci anni la mappatura tramite aerofotogrammetria ha vissuto un’evoluzione significativa, passando da sensori singoli a sistemi ibridi capaci di integrare più fonti informative.

Tra le innovazioni più recenti spicca l’UltraCam Dragon 4.1, sviluppata da Vexcel Imaging e presentata al recente workshop ISPRS-EARSeL-DGPF di Istanbul. Questo sistema rappresenta il primo esempio della casa austriaca di piattaforma completamente integrata che combina scanner LiDAR, fotocamere multi-angolari e unità GNSS/IMU in un’unica soluzione tecnologica.

Il cuore tecnologico dell’UltraCam Dragon 4.1 si fonda su tre elementi principali.

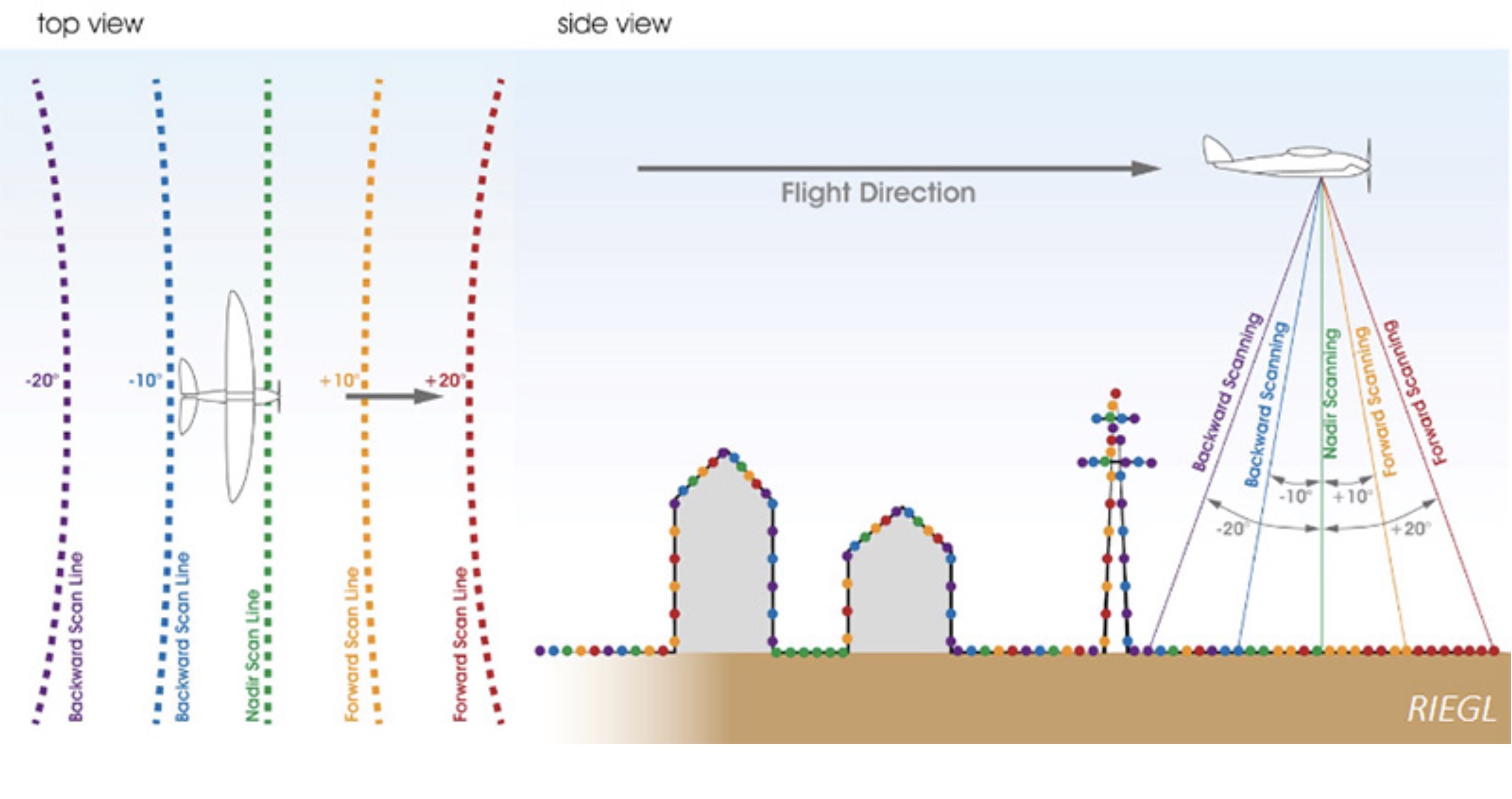

Lo scanner LiDAR Riegl VQ-680, che opera a una lunghezza d’onda di 1052 nm e può acquisire fino a due milioni di misure al secondo, utilizza uno specchio poligonale rotante per generare cinque tracce parallele: due in avanti, una nadir e due indietro. Questa configurazione, con angoli di incidenza differenziati e un campo di vista trasversale di circa ±30°, garantisce la copertura anche di facciate verticali, cortili e vicoli stretti.

Accanto al laser, un sistema di camere multiple comprende una camera RGB e una NIR nadir insieme a quattro camere oblique RGB inclinate di 45°. La possibilità di configurare ottiche di diversa lunghezza focale, unite a sensori in alcuni casi orientati verticalmente per ottimizzare il contenuto delle immagini, permette di ottenere riprese molto dettagliate e complementari.

A completare il sistema è l’UltraNav v7, che integra GNSS e IMU per la gestione del volo e la georeferenziazione diretta.

Questa architettura consente l’acquisizione sincrona di dati fotogrammetrici e laser, riducendo drasticamente gli errori di co-registrazione che caratterizzano l’integrazione di dati raccolti in momenti differenti.

La sperimentazione sul campo e la robustezza della Triangolazione Aerea

La sperimentazione sul campo è stata condotta a Graz, in Austria, nel giugno 2024. Il volo, effettuato a 1060 metri di quota con una sovrapposizione longitudinale dell’80% e laterale del 60%, ha permesso di acquisire 334 immagini nadir e oblique con una risoluzione al suolo di 5 cm (GSD), circa 250 milioni di punti LiDAR distribuiti su otto strisciate con 13 punti di controllo a terra. Questi dati sono stati poi elaborati in due diversi blocchi, uno di 250 immagini e uno di 334, con l’obiettivo di valutare come l’aggiunta di viste oblique contribuisca a migliorare la connettività e la robustezza della triangolazione aerea.

Dal punto di vista dell’elaborazione, i ricercatori hanno messo a confronto diverse strategie. L’estrazione dei punti di legame, necessaria per la triangolazione, è stata realizzata sia con metodi tradizionali basati su feature come SIFT, sia con algoritmi più recenti fondati su reti neurali, come SuperPoint e LightGlue. Questi ultimi hanno mostrato maggiore robustezza e ridondanza, soprattutto nel collegamento tra immagini oblique e nadirali, dove le distorsioni prospettiche rendono più complesso il lavoro dei metodi classici.La triangolazione aerea è stata a sua volta sperimentata secondo approcci differenti: dalla georeferenziazione diretta basata esclusivamente su dati GNSS/IMU, al Bundle Block Adjustment con punti di controllo derivati da rilievi GNSS, fino a quello che utilizza punti estratti dal cloud LiDAR.

Se il primo metodo risulta utile per applicazioni di mappatura rapida, l’approccio con GCP tradizionali ha offerto i risultati più accurati, con errori entro una Ground Sample Distance di circa 5 cm. L’uso di punti dal cloud LiDAR, pur valido, ha mostrato limiti dovuti alla difficoltà di identificazione precisa tra dataset eterogenei.

La ricostruzione tridimensionale è stata infine valutata confrontando quattro scenari: immagini nadir, immagini nadir e oblique, dati LiDAR e integrazione completa delle due fonti. I risultati hanno evidenziato come la fusione di fotogrammetria e laser scanning produca i modelli più robusti, con una densità di punti superiore e una migliore rappresentazione di facciate, tetti complessi, aree occluse o superfici a bassa texture.

L’integrazione consente di superare le rispettive debolezze: il LiDAR fornisce accuratezza altimetrica e capacità di penetrazione della vegetazione, mentre le immagini arricchiscono la scena con texture e dettagli radiometrici. Un elemento aggiuntivo di innovazione è rappresentato dalla piattaforma web MEASUREE, evoluzione del tool Geobly. Questo strumento permette di navigare e misurare grandi blocchi di immagini direttamente da un browser, senza la necessità di hardware dedicato. Offre funzionalità sia per utenti inesperti, che possono eseguire misurazioni semplici, sia per esperti che necessitano di controlli accurati e modellazioni complesse. L’implementazione online consente inoltre di gestire agevolmente dataset multi-prospettici e pesanti, che tradizionalmente risultano difficili da analizzare. Le conclusioni dello studio sottolineano come l’UltraCam Dragon 4.1 non rappresenti soltanto un passo avanti tecnologico, ma un vero e proprio cambio di paradigma. L’acquisizione simultanea di immagini ad alta risoluzione e dati LiDAR apre prospettive nuove per la modellazione urbana, il monitoraggio ambientale e la costruzione di digital twin accurati. La sfida per il futuro sarà lo sviluppo di workflow pienamente integrati e automatizzati, capaci di sfruttare appieno la complementarità tra le due tecnologie e supportati da algoritmi di intelligenza artificiale sempre più performanti.

Nota sugli algoritmi di triangolazione

Il metodo SIFT è una tecnica che permette al computer di riconoscere punti caratteristici all’interno di un’immagine, anche se questa è stata ingrandita, ruotata o illuminata in modo diverso. In pratica, il sistema individua i dettagli più “unici” della foto, ne definisce posizione e orientamento, e li descrive con una sorta di impronta digitale che facilita il confronto con altre immagini.

SuperPoint e LightGlue sono algoritmi moderni basati su reti neurali che migliorano il riconoscimento e l’abbinamento di punti caratteristici nelle immagini. A differenza dei metodi classici come SIFT, che si basano su regole matematiche predefinite, questi sistemi “imparano” da grandi quantità di dati visivi.

- SuperPoint è una rete neurale che identifica automaticamente i punti più rilevanti di un’immagine (i cosiddetti keypoints) e ne crea descrizioni robuste.

- LightGlue è un algoritmo che, partendo da queste descrizioni, riesce a collegare in modo rapido e accurato i punti corrispondenti tra immagini diverse, anche se presentano cambi di prospettiva, illuminazione o distorsioni.

Insieme rendono l’abbinamento delle immagini più affidabile, soprattutto in scenari complessi come le fotografie aeree con viste oblique o molto diverse tra loro.

| Algoritmo | Tipo | Punti di forza | Limiti |

|---|---|---|---|

| SIFT (Scale-Invariant Feature Transform) | Metodo classico, basato su trasformate e descrittori | - Invarianza a scala, rotazione e parziale invarianza all’illuminazione - Robusto e consolidato, ampiamente testato - Non richiede training |

- Computazionalmente costoso - Non adatto a real-time - Prestazioni inferiori a metodi deep learning in scenari complessi |

| SuperPoint | Deep learning (CNN) per rilevamento e descrizione | - Estrae feature e descrittori in un unico modello end-to-end - Più veloce e accurato di SIFT in molte condizioni - Funziona bene anche con texture deboli o immagini indoor |

- Richiede GPU per training (ma inference può essere veloce) - Meno interpretabilità rispetto a metodi classici - Qualità dipende dal dataset di training |

| LightGlue | Deep learning (transformer per matching) | - Specializzato nell’ottimizzare il matching dei descrittori - Adatta dinamicamente il numero di corrispondenze (efficienza adattiva) - Prestazioni SOTA per robustezza e accuratezza nel matching |

- Non rileva direttamente feature (ha bisogno di un detector tipo SuperPoint o SIFT) - Richiede GPU per funzionare in modo efficiente - Più complesso da integrare in pipeline leggere |

Ulteriori informazioni sui test effettuati sono disponibili nell'articolo:

Farella, E. M., Morelli, L., Remondino, F., Qin, R., Schachinger, B., and Legat, K.: Investigating the New Ultracam Dragon Hybrid Aerial Mapping System, Int. Arch. Photogramm. Remote Sens. Spatial Inf. Sci., XLVIII-M-6-2025, 117–125, https://doi.org/10.5194/isprs-archives-XLVIII-M-6-2025-117-2025, 2025.